【昇腾推理PaddleOCR】生产级部署方式

本文介绍了在昇腾芯片上运行PaddleOCR的优化方案。常规方法存在性能差或实现困难的缺点,作者创新性地采用PyTorch框架推理PaddleOCR模型,利用PyTorch成熟的昇腾插件,实现了0.2~0.5s的单图推理速度,经过生产环境验证稳定可靠。该方案已开源,为昇腾用户提供了兼顾性能与易用性的解决方案。

·

文章目录

想在昇腾(Ascend)上跑 PaddleOCR?这条“野路子”或许是你的最优解

在昇腾上运行 PaddleOCR,大家通常会有两条“正统”路线,但说实话,这两条路都有点“坑”。

常规路线 1:PaddlePaddle 官方支持

- 做法:直接使用 Paddle 官方提供的昇腾环境。

- 优点:简单无脑,官方出品,兼容性有保障。

- 缺点:性能奇差。在我们的实际测试中,这种方式的推理速度慢到无法在任何真实的企业场景中使用,基本属于“能跑就行”。

常规路线 2:昇腾 ACL 离线推理

- 做法:这是更专业的一条路。先把 Paddle 模型通过昇腾的工具链转换成专用的

.om格式,然后用昇腾的 C++ 推理框架(ACL)来编写和执行推理代码。 - 优点:性能天花板。这条路如果走通了,性能应该是最高的。

- 缺点:劝退级难度。学习成本极高,从模型转换到 C++ 代码开发,每一步都可能遇到各种意想不到的问题。就算你最终把整个流程跑通了,后期调试和优化也极其困难。目前网上几乎找不到一套完整的、能稳定复现的解决方案。

柳暗花明:一条兼顾性能与易用性的“野路子”

两条“正路”都走不通,我们因为工作需要,硬是蹚出了一条“野路子”,结果发现效果出奇地好。

核心思路:换个框架,用 PyTorch 来推理 PaddleOCR 模型!

你可能觉得有点绕,但逻辑是这样的:虽然 PaddlePaddle 官方对昇腾的支持不尽如人意,但 PyTorch 有相对成熟的昇腾插件。我们完全可以“借鸡生蛋”。

我们把这个想法付诸实践并开源了,效果非常惊艳:

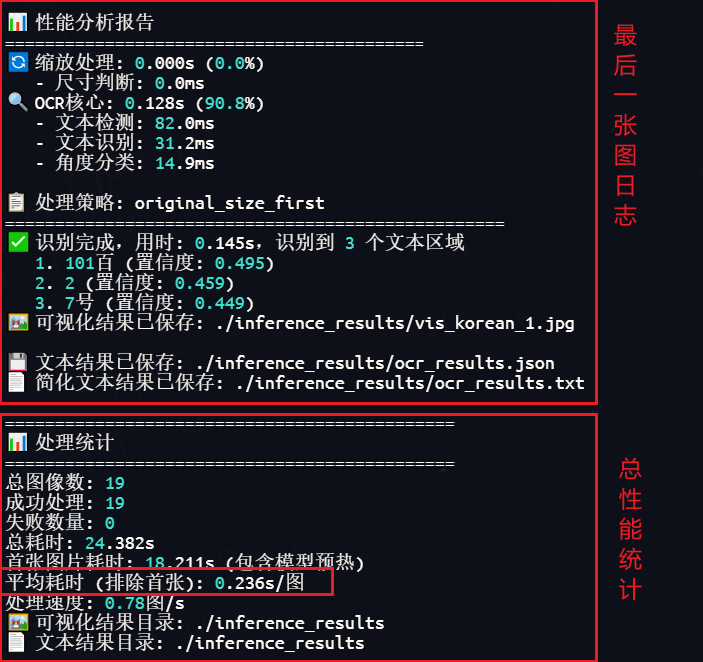

- 🚀 性能强劲:单张图片推理耗时仅 0.2~0.5s,如果用上批处理优化,可以再次压缩性能。

- 👍 稳定可靠:这套方案已经在企业生产环境中经过了 7x24 小时 的稳定运行考验,精度和稳定性都完全达标。

- 🔧 部署友好:唯一的“缺点”是处理大尺寸图片时显存占用会高一些,推荐单独用一张 NPU 卡来部署服务。实际上问题不大。

在目前官方支持尚不完善的情况下,这套方案,绝对是兼顾高性能、高稳定性和低开发成本的首选。

效果展示

处理日志示例

可视化结果示例

开源地址⭐

我们已经将这套生产级的昇腾高性能推理方案完全开源,希望能帮助到更多有同样需求的开发者。

如果这个项目对你有帮助,期待你的⭐ Star ⭐支持一下!

项目地址:https://github.com/momomo623/PaddleOCR-NPU

本文经LLM优化,阅读起来可能有股AI味 ~~

昇腾计算产业是基于昇腾系列(HUAWEI Ascend)处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,包括昇腾系列处理器、系列硬件、CANN、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)